LLM 模型测试

hugging face 下载模型

首先在 poweshell 下设置代理,该方式只在 session 中生效

1 | $env:HTTP_PROXY="http://username:password@xxxx.xxxx.xxxx.xxxx:3030" |

下载指定模型,如果是 llama,请先登录,获取授权

1 | huggingface-cli login |

llama.cpp

构建 llama.cpp 环境

1 | git clone https://github.com/ggerganov/llama.cpp.git |

验证依赖安装是否正确

1 | python convert_hf_to_gguf.py |

如上即为正常。

转换 model 为 gguf 格式

1 | python convert_hf_to_gguf.py models/Llama-3.2-1B/ |

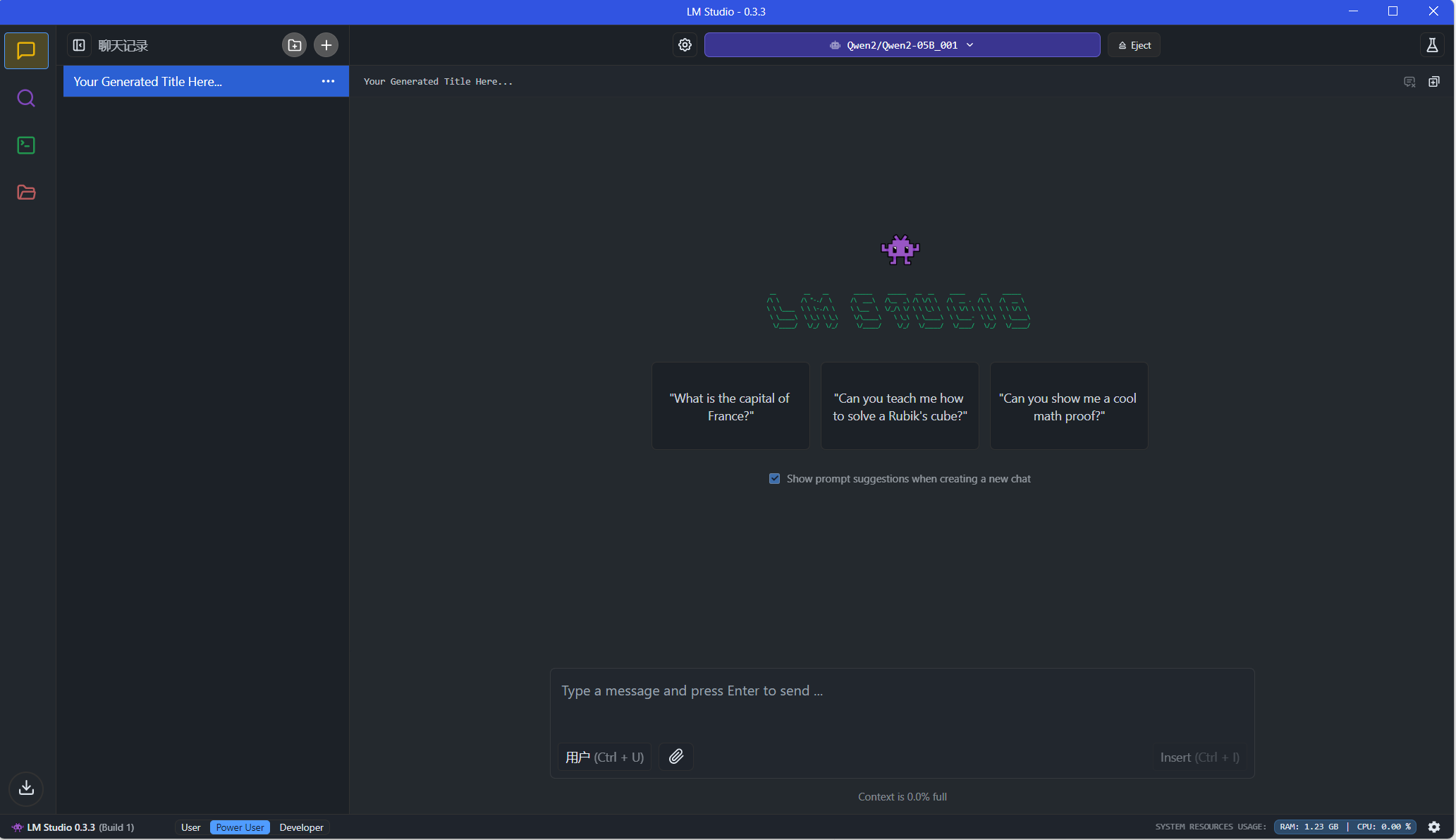

LM Studio

将编译好的 gguf 模型放置在C:\Users\用户名\.cache\lm-studio\models\,即可识别本地模型。

例如:

1 | "C:\Users\用户名\.cache\lm-studio\models\meta-llama\Llama-3.2-1B\Llama-3.2-1B-F16.gguf" |

Ollama

ollama load gguf

Modelfile

1 | FROM ./Llama-3.2-1B-F16.gguf |

加载模型

1 | ollama create llama3.2:1b -f .\Modelfile |

运行模型

1 | ollama run llama3.2:1b |